فایل نقشه سایت XML و Robots.txt؛ دو ابزار کلیدی برای کمک به موتورهای جستجو برای درک و ایندکس صحیح وب سایت هستند.

چرا نقشه سایت و robots.txt اهمیت دارند؟

ترکیب این دو فایل لیستی جامع و دقیق از محتوا و صفحاتی هستند که مایلید موتورهای جستجو ایندکس کنند و نحوهی سازماندهی کل صفحات را مشخص میکنند.

چه باید کرد؟

در نقشه سایت مشخص کنید کدام صفحات ایندکس یا نوایندکس شوند.

پوشهها یا فایلهایی که نمیخواهید ایندکس شوند در فایل robots.txt مسدود کنید.

تفاوت فایل robots.txt و نقشه سایت چیست؟

نقشه سایت یک فایل XML است که تمام URLها یا صفحات وب سایتهای شما را ایندکس میکند. نقشه سایت ساختار کلی و روابط متقابل محتوای سایت شما را به موتورهای جستجو نشان میدهد و هدفش هدایت رباتها برای کرال صفحات وبسایت شماست.

فایل Robots.txt به موتورهای جستجو نشان میدهد که کدام صفحات را بخزند و کدام را حذف کنند.

۳ دلیل مهم برای استفاده از فایل robots.txt

مسدود کردن صفحات غیر عمومی: صفحاتی که نمیخواهید ایندکس شوند. مثلا ممکن است صفحهی لندینگی باشد که برای کمپینی خاص ایجاد میشود و در هیچ یک از مسیرهای سفر مشتری لحاظ نشده و نمیخواهید افراد تصادفی روی چنین صفحاتی فرود بیایند. در این شرایط است که از robots.txt برای جلوگیری از کرال استفاده میکنید.

به حداکثر رساندن کرال باجت یا بودجه خزش: ایندکس همهی صفحات سایت ممکن است شما را با مشکل بودجه خزش مواجه کند. با مسدود کردن صفحات بیاهمیت با robots.txt، Googlebot میتوانید بودجه خزش سایت را صرف صفحاتی کنید که واقعاً مهم هستند.

جلوگیری از ایندکس منابع: استفاده از تگهای متا میتواند به همان اندازه Robots.txt برای جلوگیری از ایندکس شدن صفحات کار کند. با این حال دستورالعملهای متا برای منابع چندرسانهای مانند فایلهای PDF و تصاویر به خوبی اعمال نمیشود. اینجاست که robots.txt به کار میآید.

نتیجه نهایی؟

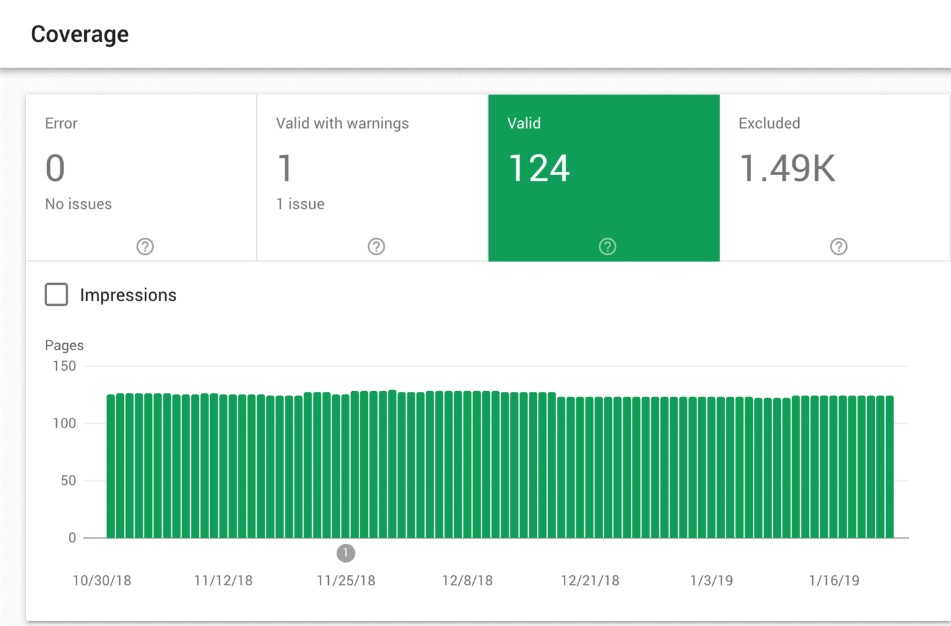

گزارش صفحاتی که ایندکس شدند در سرچ کنسول قابل بررسی است.

اگر تعداد صفحاتی که معتبر شناخته شدند با تعداد صفحاتی که میخواهید ایندکس شوند مطابقت دارد، نیازی نیست خودتان را برای ایجاد و تنظیم فایل Robots.txt به زحمت بیاندازید.

اما اگر این عدد بیشتر از چیزی است که انتظار داشتید (و متوجه URLهایی شدید که برخلاف میل شما ایندکس شدند باید یک فایل robots.txt برای وب سایت خود ایجاد کنید.

بهترین کار چیست؟

یک فایل Robots.txt ایجاد کنید

فایل robots.txt فایل متنی که میتوانید با استفاده از notepad ویندوز آن را ایجاد کنید.

البته در نهایت اینکه چگونه فایل robots.txt خود را میسازید، اهمیت چندانی ندارد اما فرمت آن باید به شکل زیر باشد :

User-agent: X

Disallow: Y

User-agent ربات خاصی است که شما با آن صحبت میکنید و هر چیزی که بعد از “Disallow” میآید صفحات یا بخشهایی هستند که قصد مسدود کردن آنها را دارید.

مثال:

User-agent: googlebot

Disallow: /images

این دستور به Googlebot میگوید که فولدر تصاویر وبسایت شما را ایندکس نکند.

همچنین میتوانید از یک ستاره (*) برای صحبت با همه رباتهایی استفاده کنید که از وبسایت شما گذر میکنند.

مثال:

User-agent: *

Disallow: /images

“*” به همه اسپایدرها یا رباتها میگوید که فولدر تصاویر شما را کرال نکنند.

مثال بالا تنها یکی از راههای استفاده از فایل robots.txt است. راهنمای رسمی گوگل اطلاعات بیشتری در مورد دستورات مختلفی دارد که میتوانید از آنها برای مسدود کردن یا اجازه خزیدن رباتها در صفحات مختلف سایت خود استفاده کنید.

سایر پیشنهادات برای فایل robots.txt سایت

- پیدا کردن فایل Robots.txt خود را آسان کنید

- اگر فایل robots.txt دارید، گاهی بروزرسانی کنید

- از نظر فنی میتوانید فایل robots.txt خود را در هر دایرکتوری اصلی سایت قرار دهید.

- اما برای افزایش شانس یافتن فایل robots.txt، توصیه میشود آن را در این آدرس قرار دهید:

https://example.com/robots.txt

(توجه داشته باشید که فایل robots.txt شما به حروف کوچک و بزرگ حساس است. بنابراین مطمئن شوید که از یک “r” کوچک در نام فایل استفاده کنید)

- خطاها و اشتباهات را بررسی کنید.

همچنین بسیار مهم است که فایل robots.txt شما به درستی تنظیم شود. با یک اشتباه ممکن است کل سایت شما از لیست فهرست و ایندکس گوگل خارج شود.

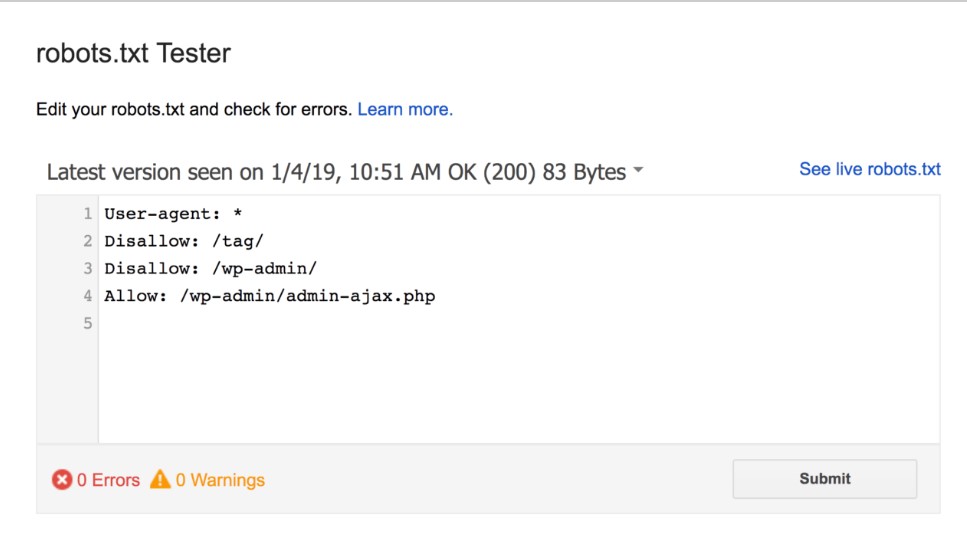

خوشبختانه نیازی نیست نگران تنظیم صحیح کد باشید. گوگل ابزاری قوی برای تست ربات دارد که میتوانید برای بررسی صحت فایل از آن استفاده کنید:

فایل robots.txt هر خطا و هشداری را که پیدا کند نشان میدهد.

مثلا همانطور که میبینید، صفحه مدیریت وردپرس خود را مسدود میکنیم تا رباتها آن را کرال نکنند.

همچنین به صورت خودکار با استفاده از robots.txt مانع خزش صفحاتی میشویم که با برچسبهای وردپرس ایجاد کردیم تا محتوای تکراری نداشته باشیم.

Robots.txt در مقابل دستورات متا

چرا وقتی میتوانید صفحاتی را در سطح صفحه با متا تگ «noindex» مسدود کنید، از robots.txt استفاده شود؟

۱- همانطور که قبلاً اشاره کردم تگ noindex برای پیادهسازی روی منابع چندرسانهای مانند فیلمها و فایلهای PDF چالش دارد.

۲- اگر تعداد صفحات سایت زیاد باشد مثل بسیاری از سایتهای فروشگاهی که بالای هزاران صفحه دارند. اگر بخواهید به صورت دستی متا تگ نوایندکس به هر صفحه اضافه کنید مسدود کردن همهی صفحاتی که نمیخواهید ایندکس باشند در فایل robots.txt آسانتر است.

۳- مواردی هم وجود دارد که نمیخواهید کرال باجت را برای فرود گوگل در صفحاتی با تگ نوایندکس هدر دهید.

خارج از این ۳ حالت توصیه میشود به جای robots.txt از متاتگها استفاده کنید. چراکه اجرا و پیادهسازی آنها آسانتر است و احتمال وقوع فجایعی مانند مسدود شدن کل سایت کمتر است.